Welcome to Our Development Story

This book documents the fascinating journey behind the development of Notion Assistant, an open-source AI assistant for Notion.

Throughout these pages, we share:

- 📚 Our story and motivation for creating this project

- 🧠 The learnings and challenges we faced

- 🔧 The technical solutions we implemented

- 🙏 Special thanks to those who made this possible

This documentation serves as a complement to the full technical documentation for developers, focusing more on the human aspects and lessons learned during the development process.

Note: For detailed technical documentation on how to use, configure, and contribute to the project, refer to our developer documentation.

Why Are We Sharing Our Journey?

We believe the process of building is as valuable as the final product. By documenting our experience:

- We inspire other developers to start their own open-source projects

- We share solutions to common problems others might face

- We celebrate the community that made this project possible

- We document our evolution for future reference

We hope this account serves as inspiration and a reference for developers, AI enthusiasts, and anyone interested in how software solutions are built in practice.

This is an open-source project built with ❤️ and lots of ☕

Docker for Development

The Evolution of Our Development Environment

When we started developing NotionAiAssistant, we quickly realized that a consistent and easy-to-set-up development environment would be essential for the project's success, especially as an open-source initiative aiming to attract contributors.

graph LR

subgraph "Before: Fragmented Development"

PL["Local<br>Python"] --> P1["Environment<br>Inconsistencies"]

PL --> P2["Different<br>Versions"]

P3["Complex<br>Setup"]

end

subgraph "After: Unified Docker"

DC["Docker<br>Compose"] --> B1["Hot<br>Reload"]

DC --> B2["Synced<br>Volumes"]

DC --> B3["Consistent<br>Environment"]

end

I["Developer"] --> A

I --> D

A -.-> |Evolution| D

classDef before fill:#ffcccc,stroke:#333,stroke-width:2px

classDef after fill:#ccffcc,stroke:#333,stroke-width:2px

classDef dev fill:#bbf,stroke:#333,stroke-width:2px

class A,PL,P1,P2,P3 before

class D,DC,B1,B2,B3 after

class I dev

The Initial Challenge: Local Python Development

Initially, our development workflow was fragmented:

- Python running locally on the developer's machine

- PostgreSQL database in a separate Docker container

- Streamlit frontend in another local process

This model presented several problems:

- Environment inconsistencies: "It works on my machine" was a recurring issue

- Complex setup: New contributors had to follow detailed instructions

- Different dependency versions: Caused hard-to-track bugs

- High technical knowledge requirement: Barrier for less experienced contributors

The Solution: Hot Reload in Docker for Development

Our major evolution was implementing a Docker development environment with integrated hot reload:

# Excerpt from our Dockerfile.dev

FROM python:3.10-slim as dev

WORKDIR /app

# Install dependencies with uv for faster speed

COPY requirements-dev.txt .

RUN pip install --no-cache-dir uv

RUN uv pip install --no-cache-dir -r requirements-dev.txt

# Hot reload configuration

ENV PYTHONDONTWRITEBYTECODE=1

ENV PYTHONUNBUFFERED=1

# Entry point that starts the app with hot reload

ENTRYPOINT ["python", "-m", "uvicorn", "app.main:app", "--host", "0.0.0.0", "--port", "8080", "--reload"]

Combined with volume mapping in docker-compose:

# Excerpt from docker-compose.dev.yml

services:

app:

build:

context: .

target: dev

volumes:

- ./app:/app/app

- ./config:/app/config

# ...

Transformative Benefits

This approach brought extraordinary benefits:

1. Amplified Productivity

- Automatic hot reload: Code changes are instantly reflected in the browser

- Immediate feedback: Developers see results without restarting containers

- Continuous workflow: Fewer interruptions, more productivity

2. Simplified Experience for Contributors

- Single command to start:

docker-compose -f docker-compose.dev.yml up - No complex local setup: Everything works inside the container

- Consistent environment: All developers have exactly the same setup

3. Accessibility for Different Experience Levels

- Python developers: Can contribute without deep Docker knowledge

- Beginner developers: Significantly reduced entry barrier

- Non-technical contributors: Can easily test and provide feedback

How It Works in Practice

The workflow became incredibly simple:

-

Clone the repository:

git clone https://github.com/your-username/NotionAiAssistant.git cd NotionAiAssistant -

Start the development environment:

docker-compose -f docker-compose.dev.yml up -

Start developing:

- Edit files in your favorite IDE

- Changes are detected automatically

- The app reloads in seconds

- See changes in the browser in real-time

Before and After Comparison

| Aspect | Before | After |

|---|---|---|

| Time to start | 5-10 minutes | 1-2 minutes |

| Initial setup | Complex, multiple steps | Single command |

| Feedback after changes | 30-60 seconds | 1-2 seconds |

| Consistency among devs | Variable | 100% consistent |

| Contribution barrier | High | Low |

Lessons and Best Practices

Our experience taught us some valuable practices:

- Prioritize developer experience from the start of the project

- Optimize feedback time - the faster, the better

- Simplify onboarding for new contributors

- Document clearly the development workflow

- Test your environment with developers of different experience levels

Impact on the Project

Implementing hot reload in Docker fundamentally transformed our project:

- Increased contributions: More people could participate easily

- Faster development cycles: Features implemented in less time

- Better code quality: More iterations and experimentation

- More engaged community: Reduced barrier to participation

This approach became one of the pillars of our project's philosophy: advanced technology that feels simple for the end user.

"The best tool isn't the one with the most features, but the one that removes obstacles from your path."

Security with Docker Secrets

The Challenge of Managing Secrets in Applications

Managing secrets and sensitive configurations is a critical challenge in any application, especially in open-source projects. From the beginning of NotionAiAssistant, we considered security a priority, and proper management of credentials and API tokens was essential.

graph LR

subgraph "Docker Secrets Flow"

S1["Secrets Files<br>Local/CI/Production"] --> S2["Docker Compose<br>References Secrets"]

S2 --> S3["Mounted at<br>/run/secrets/"]

S3 --> S4["Application<br>Reads from Filesystem"]

end

subgraph "Security Benefits"

S4 --> V1["Not Visible<br>in Logs"]

S4 --> V2["Not Exposed<br>in Variables"]

S4 --> V3["Not Included<br>in Images"]

end

classDef source fill:#f9f,stroke:#333,stroke-width:2px

classDef flow fill:#bbf,stroke:#333,stroke-width:2px

classDef benefit fill:#bfb,stroke:#333,stroke-width:2px

class S1 source

class S2,S3,S4 flow

class V1,V2,V3 benefit

Why Docker Secrets?

There are several secret management solutions available in the market, such as:

- HashiCorp Vault

- AWS Secrets Manager

- Google Secret Manager

- Kubernetes Secrets

- Encrypted environment variables

- .env files with tools like dotenv

However, we chose Docker Secrets for the following reasons:

1. Native Integration with Our Stack

Since we were already using Docker and Docker Compose for our development and production environments, Docker Secrets offered seamless integration without additional tools.

2. Simplicity and Low Learning Curve

Docker Secrets provides a straightforward and intuitive approach:

# Example usage in docker-compose.yml

services:

app:

image: notionaiassistant:latest

secrets:

- notion_api_key

- database_password

- openai_api_key

secrets:

notion_api_key:

file: ./secrets/notion_api_key.txt

database_password:

file: ./secrets/database_password.txt

openai_api_key:

file: ./secrets/openai_api_key.txt

3. Security Across Different Environments

Docker Secrets allowed us to implement a consistent strategy for different environments:

- Development: Secrets stored locally in files

- CI/CD: Secrets injected from environment variables

- Production: Secrets managed by Docker Swarm

4. Prevents Accidental Exposure

Docker Secrets significantly reduces the risk of accidental credential exposure:

- Not visible in logs or command outputs

- Not exposed through environment variables

- Not included in images or containers

- Mounted as temporary files in

/run/secrets/

Implementation in NotionAiAssistant

Our Docker Secrets implementation follows a consistent pattern throughout the project:

1. Directory Structure

NotionAiAssistant/

├── secrets/

│ ├── .gitignore # Ignores all files except templates

│ ├── notion_api_key.txt.template

│ ├── database_password.txt.template

│ └── ...

2. Accessing Secrets in Code

We implemented a helper function to access secrets consistently:

def get_secret(secret_name: str) -> str:

"""

Gets a secret from Docker Secrets or falls back to environment variables.

Args:

secret_name: Name of the secret to retrieve

Returns:

Secret content as a string

"""

# Default Docker Secrets path

secret_path = f"/run/secrets/{secret_name}"

# Check if the secret exists as a file

if os.path.exists(secret_path):

with open(secret_path, "r") as f:

return f.read().strip()

# Fallback to environment variable (local development or CI)

env_var = os.environ.get(secret_name.upper())

if env_var:

return env_var

raise ValueError(f"Secret {secret_name} not found")

3. Setup for New Contributors

We created a setup script to simplify initial configuration:

#!/bin/bash

# setup-secrets.sh

echo "Setting up secrets for development environment..."

mkdir -p secrets

for template in secrets/*.template; do

secret_file="${template%.template}"

if [ ! -f "$secret_file" ]; then

echo "Creating $secret_file"

echo "development_value" > "$secret_file"

echo "⚠️ Remember to replace the default value in $secret_file with your actual credentials"

fi

done

echo "✅ Setup complete!"

Practical Benefits Observed

Adopting Docker Secrets brought tangible benefits to the project:

- Zero accidental exposure of credentials in commits or logs

- Simplified onboarding process for new contributors

- Consistency across development and production environments

- Easier credential rotation without rebuilding images

- Improved auditability of access to sensitive information

Comparison with Alternatives

| Solution | Complexity | Docker Integration | Learning Curve | Cost |

|---|---|---|---|---|

| Docker Secrets | Low | Native | Low | Free |

| HashiCorp Vault | High | Requires setup | High | Free/Paid |

| Cloud Providers | Medium | Requires SDK/API | Medium | Paid |

| .env Files | Low | Manual | Low | Free |

Lessons Learned

Our experience with Docker Secrets taught us important lessons:

- The simplest solution is often the best: We didn't need complex tools to solve basic problems

- Native solutions reduce friction: Using what's already available in the ecosystem minimizes failure points

- Clear documentation is essential: Especially for security-related aspects

- Consistent patterns enhance security: A uniform approach simplifies auditing and maintenance

Conclusion

Choosing Docker Secrets demonstrated that, in many cases, the native tools of your ecosystem can offer elegant solutions to complex problems. Instead of adding more complexity with specialized tools, first evaluate what's already available in your current stack.

This approach aligns perfectly with our project philosophy: using simple, effective open-source technologies to create robust and accessible solutions.

"Simplicity is the ultimate sophistication." - Leonardo da Vinci

GitHub and CI/CD

The Magic of GitHub in Project Evolution

Choosing GitHub as the platform to host our project was one of the key factors in NotionAiAssistant's success. Far beyond a simple code repository, GitHub became the nerve center of our entire development, collaboration, and continuous delivery process.

graph LR

subgraph "Development Flow"

D1["Developer<br>Creates Branch"] --> D2["Implements<br>Feature/Fix"]

D2 --> D3["Creates Pull<br>Request"]

end

D3 --> C1

subgraph "CI/CD Pipeline"

C1["GitHub Actions<br>Detects PR"] --> C2["Tests and<br>Linters"]

C2 -->|Passes| C3["Peer<br>Review"]

C3 -->|Approved| C4["Merge<br>to Main"]

C4 --> C5["Automatic<br>Deploy"]

C2 -.->|Fails| D2

end

classDef dev fill:#bbf,stroke:#333,stroke-width:2px

classDef ci fill:#f9f,stroke:#333,stroke-width:2px

classDef deploy fill:#bfb,stroke:#333,stroke-width:2px

class D1,D2,D3 dev

class C1,C2,C3,C4 ci

class C5 deploy

Version Control: The Foundation of Everything

The Git version control system, combined with GitHub's intuitive interface, provided us with:

1. Complete and Transparent History

Every decision, implementation, and fix is documented through commits and pull requests, creating a complete history of the project's evolution.

# Example of a commit log that tells a story

$ git log --oneline --graph --decorate --all

* a1b2c3d (HEAD -> main) Optimizes performance of text block search

* e4f5g6h Adds support for table formatting in Notion

* i7j8k9l Fixes bug in splitting large content

* m0n1o2p Implements smart chunking algorithm

* q3r4s5t Initial version of Notion API integration

2. Facilitated Collaboration

GitHub's fork and pull request model democratized contributions to the project:

- Developers can experiment in their own forks

- Pull requests enable detailed code reviews

- Discussions are permanently documented

- Occasional contributors can participate without direct repository access

3. Release and Tag Management

GitHub simplified our semantic versioning process:

- Tags to mark stable releases

- Releases with detailed notes

- Compiled assets available for download

- Clearly documented changelog

GitHub Actions: Effortless CI/CD

The real magic happened when we implemented GitHub Actions to automate our continuous integration and delivery pipeline.

1. Automated Tests on Every PR

# Excerpt from our test workflow

name: Tests

on:

pull_request:

branches: [ main ]

push:

branches: [ main ]

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python

uses: actions/setup-python@v4

with:

python-version: '3.10'

- name: Install dependencies

run: |

python -m pip install --upgrade pip

pip install uv

uv pip install -r requirements-dev.txt

- name: Run tests

run: pytest

- name: Run linters

run: make lint

This workflow ensures:

- All tests pass before merging

- Code follows defined style standards

- Issues are identified early

2. Automated Production Deploy

Our deploy pipeline is triggered automatically when changes are pushed to the main branch:

# Excerpt from our deploy workflow

name: Deploy

on:

push:

branches: [ main ]

jobs:

deploy:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Docker Buildx

uses: docker/setup-buildx-action@v2

- name: Build and push

uses: docker/build-push-action@v4

with:

context: .

push: true

tags: ${{ secrets.DOCKER_REGISTRY }}/notionaiassistant:latest

- name: Deploy to server

uses: appleboy/ssh-action@master

with:

host: ${{ secrets.SERVER_HOST }}

username: ${{ secrets.SERVER_USER }}

key: ${{ secrets.SSH_PRIVATE_KEY }}

script: |

cd /opt/notionaiassistant

docker-compose pull

docker-compose up -d

This workflow automates the entire delivery process:

- Builds a new Docker image

- Pushes to the container registry

- Deploys to the production server

- All without manual intervention

3. Additional Quality Workflows

Beyond the main workflows, we implemented additional automations:

- Dependency checks: Dependabot to keep libraries updated

- Environment previews: Temporary environments to test pull requests

- Documentation generation: Automatic updates to documentation

- Code analysis: Integration with tools like CodeQL for security

Issues and Projects: Transparent Management

GitHub's Issues system became our central hub for:

- Bug tracking: Detailed and reproducible reports

- Feature requests: Discussions about new implementations

- Release planning: Visual organization with GitHub Projects

- Decision documentation: Discussions leading to architectural choices

The public nature of this process allowed users and contributors to actively participate in guiding the project.

GitHub Pages: Accessible Documentation

We used GitHub Pages to host our documentation:

- Automatically generated from source code

- Updated with every push to the main branch

- Integrated with mdbook for a pleasant reading experience

- Accessible via a custom domain

Lessons Learned

Our experience with GitHub and CI/CD taught us:

- Automate everything possible: Every manual step is an opportunity for errors

- Tests are essential: There's no effective CI/CD without good test coverage

- Fast feedback is crucial: Workflows should be optimized for speed

- Documentation should evolve with code: Automate its updates

- Transparency benefits everyone: Open processes foster collaboration

Tangible Benefits Observed

Adopting these practices resulted in:

- 90% reduction in deploy time: From hours to minutes

- Fewer bugs in production: Issues are detected before merging

- Increased developer confidence: Changes can be made safely

- Greater community engagement: Contributors easily understand the process

Conclusion

GitHub and its integrated CI/CD tools were fundamental in transforming NotionAiAssistant from a personal project into a robust, collaborative solution. The "magic" of GitHub lies not just in its technical tools but in how they facilitate human collaboration and promote high-quality development practices.

We strongly recommend that any open-source project fully leverage these resources, as they significantly amplify the impact and quality of community contributions.

"Code is just one part of software development. Collaboration, processes, and tools are equally important."

Working Around Notion API Limits

The Challenge of API Limitations

One of the biggest technical challenges we faced while developing NotionAiAssistant was dealing with the limitations of the Notion API, especially when creating pages with extensive Markdown-formatted content.

flowchart TD

A[Markdown Content] --> B{Notion API Limitations}

B -->|2000-character limit per block| C[Smart Content Splitting]

B -->|Special formatting for Markdown| D[Custom Markdown Parser]

B -->|100-block limit per request| E[Batch Processing]

C --> F[Smart Chunking Algorithm]

D --> G[Markdown to Notion Blocks Mapping]

E --> H[Processing Queue with Retry]

F --> I[Final Result]

G --> I

H --> I

I --> J[Notion Page with Complete Formatted Content]

style B fill:#f96,stroke:#333,stroke-width:2px

style I fill:#9f6,stroke:#333,stroke-width:2px

style J fill:#69f,stroke:#333,stroke-width:2px

The Three Main Limitations

The Notion API imposes three significant restrictions that directly impacted our implementation:

1. 2000-Character Limit per Text Block

"Error: Content exceeds the maximum limit of 2000 characters per block"

This limit made it impossible to directly create large text blocks, such as articles, extensive documentation, or reports, which are common in productive environments.

2. Special Formatting Required for Markdown

Notion does not accept raw Markdown in its API. Instead, it requires a specific block structure with its own formatting, making the conversion of Markdown content to the API's expected format complex.

3. 100-Block Limit per Request

"Error: Maximum number of blocks per request exceeded (max: 100)"

This limitation meant that even after splitting content into smaller blocks, we still needed to manage multiple requests for very extensive content.

Our Implemented Solution

To work around these limitations, we developed a solution composed of three main components:

1. Smart Content Splitting

We created a "chunking" algorithm that:

- Splits text into blocks smaller than 2000 characters

- Respects content structure (paragraphs, lists, code blocks)

- Preserves Markdown formatting during splitting

- Intelligently handles elements like tables and images

def smart_chunk_content(markdown_text, max_length=1900):

chunks = []

current_chunk = ""

for line in markdown_text.split('\n'):

if len(current_chunk + line + '\n') > max_length:

if current_chunk:

chunks.append(current_chunk)

current_chunk = line + '\n'

else:

current_chunk += line + '\n'

if current_chunk:

chunks.append(current_chunk)

return chunks

2. Markdown to Structured Notion Blocks

We developed a custom Markdown parser that:

- Converts Markdown elements to Notion's block format

- Preserves styles like bold, italic, inline code

- Correctly maps headers, lists, and code blocks

- Maintains links, images, and other complex elements

3. Batch Processing Respecting Block Limits

To handle the 100-block limit per request, we implemented:

- Grouping blocks into batches of up to 100

- A queue system to process requests sequentially

- A retry mechanism with exponential backoff

- Progress monitoring for long operations

Results and Benefits

This solution allowed us to:

- Create Notion pages with virtually unlimited content

- Preserve all original Markdown formatting

- Offer a seamless user experience

- Work around API limitations without compromising functionality

Lessons Learned

Developing this solution taught us:

- The importance of understanding third-party API limitations

- The value of custom algorithms for specific problems

- The need for extensive testing with different content types

- The benefits of a modular approach

"Limitations live only in our minds. But if we use our imagination, our possibilities become limitless." - Jamie Paolinetti

UV vs PIP: Speeding Up Python Builds

The Build Speed Problem

One of the challenges that significantly impacted our productivity was the Docker build time during Python development. The traditional process of installing Python dependencies using pip was taking approximately 3 minutes for each full build.

graph LR

subgraph "Performance Comparison"

P["pip<br>~3 minutes"] --> C{Comparison}

U["uv<br>~30 seconds"] --> C

end

subgraph "Development Impact"

C --> D["Fragmented<br>Development"]

C --> I["Integrated<br>Development"]

D --> DL["Local Python"]

D --> DB["Separate DB"]

D --> DF["Separate Frontend"]

I --> ID["Complete Docker"]

I --> IH["Hot Reload"]

I --> IC["Fast CI/CD"]

end

classDef pip fill:#ff9999,stroke:#333,stroke-width:2px

classDef uv fill:#99ff99,stroke:#333,stroke-width:2px

classDef fragmented fill:#ffcccc,stroke:#333,stroke-width:2px

classDef integrated fill:#ccffcc,stroke:#333,stroke-width:2px

class P pip

class U uv

class D,DL,DB,DF fragmented

class I,ID,IH,IC integrated

This excessive build time had direct consequences:

- Reduced productivity: Developers had to wait long periods after each change

- Fragmented development: Many opted to develop with local Python, separate databases, and frontends

- Additional complexity: Maintaining separate environments led to inconsistencies and hard-to-track bugs

- Difficulty for new contributors: The setup process was complicated and time-consuming

Discovering UV: A Python Installer in Rust

During our search for solutions, we discovered UV, a Python dependency installer and resolver developed in Rust by the open-source community.

What Makes UV Special?

- Developed in Rust: A language known for its performance and safety

- Efficient parallelism: Installs and resolves dependencies simultaneously

- Smart caching: Reuses downloaded packages efficiently

- Compatibility: Works as a direct replacement for pip

- Open-source: Actively maintained by the community

The Transformation: From 3 Minutes to 30 Seconds

Replacing pip with UV in our build process resulted in a dramatic reduction in build time:

| Tool | Average Build Time | Impact on Productivity |

|---|---|---|

| pip | ~3 minutes | Fragmented development |

| uv | ~30 seconds | Integrated workflow |

This performance improvement of approximately 6x completely transformed our development workflow.

Implementation in Dockerfile

The implementation was surprisingly simple. We replaced pip with UV in our development Dockerfile:

# Before (with pip)

FROM python:3.10-slim as dev

WORKDIR /app

COPY requirements-dev.txt .

RUN pip install --no-cache-dir -r requirements-dev.txt

# After (with uv)

FROM python:3.10-slim as dev

WORKDIR /app

COPY requirements-dev.txt .

RUN pip install --no-cache-dir uv

RUN uv pip install --no-cache-dir -r requirements-dev.txt

Benefits Beyond Speed

Adopting UV brought additional benefits beyond just reducing build time:

- Unified development environment: All developers started using the same Docker setup

- Easier onboarding: Much faster and simpler setup for new contributors

- Hot-reload development: Enabled the implementation of hot-reload in Docker

- More reliable dependency resolution: Fewer conflicts and compatibility issues

- Better resource utilization: More efficient CPU and memory usage during builds

Why Two Dockerfiles?

One question that arose was: "Why maintain two separate Dockerfiles (dev and prod) instead of unifying them?"

Our decision was based on several considerations:

-

Optimization for different use cases:

- Development Dockerfile: Prioritizes build speed and ease of development

- Production Dockerfile: Prioritizes security, image size, and stability

-

Development-specific tools:

- The development environment includes tools like debuggers and hot-reload

- The production environment is leaner and optimized

-

Ease for contributors:

- Developers can start the complete environment with a single command

- No deep knowledge of infrastructure, CI/CD, or networking is required

This separation allowed us to optimize each environment for its specific purpose, making the project more accessible to new contributors.

Lessons Learned

This experience taught us valuable lessons:

- Tools matter: Choosing the right tools can dramatically transform productivity

- Rust for performance: Systems languages like Rust can bring significant benefits to development tools

- Experimentation is worth it: Trying new approaches, even unconventional ones, can lead to major improvements

- Open-source community: Leveraging community work can solve seemingly intractable problems

Impact on the Project as a Whole

Adopting UV was one of the biggest contributors to developer productivity and satisfaction in the project. What started as a technical optimization fundamentally transformed how we work and collaborate.

"Time is the most valuable resource we have; it's great that there's a way to compile Python in 30 seconds instead of 3 minutes."

Setting Up MDBook with Mermaid and JotDown

This guide explains how to configure MDBook with Mermaid.js support to create interactive diagrams in documentation, and how we integrated JotDown for a seamless workflow between Notion and our documentation.

Prerequisites

- Rust and Cargo installed

- Node.js (for Mermaid.js)

MDBook Installation

- Install MDBook:

cargo install mdbook --version 0.4.40

- Install MDBook Mermaid plugin:

cargo install mdbook-mermaid --version 0.15.0

Configuration

- Create a

book.tomlfile with:

[book]

title = "Documentation"

authors = ["Your Team"]

[preprocessor.mermaid]

command = "mdbook-mermaid"

[output.html]

additional-js = ["mermaid.min.js", "mermaid-init.js"]

- Download Mermaid.js v8.11.0:

curl -o mermaid.min.js https://cdn.jsdelivr.net/npm/mermaid@8.11.0/dist/mermaid.min.js

- Create

mermaid-init.js:

window.mermaid.initialize({startOnLoad: true});

JotDown Integration

To streamline our workflow between Notion and our MDBook documentation, we integrated JotDown, which provided several key benefits:

Setting Up JotDown

- Clone and build the JotDown repository:

git clone https://github.com/Harry-027/JotDown

cd JotDown

cargo build --release

- Configure Notion API token in your environment:

export NOTION_TOKEN="your_notion_integration_token"

- Configure your MCP client (such as Claude desktop) to use JotDown for automated documentation generation.

Benefits of JotDown in Our Workflow

- Content Synchronization: Automatically pulls content from Notion into our MDBook structure

- Consistency: Maintains consistent formatting between Notion and MDBook

- Automation: Reduces manual tasks in converting Notion pages to MDBook chapters

- Efficiency: Significantly speeds up the documentation process

Usage

Add Mermaid diagrams in Markdown files:

```mermaid

graph TD

A[Start] --> B{Decision}

B -->|Yes| C[Result]

B -->|No| D[Alternative]

```

Supported Diagram Types

- Flowcharts (

graph) - Sequence diagrams (

sequenceDiagram) - Class diagrams (

classDiagram) - Gantt charts (

gantt) - Pie charts (

pie)

Troubleshooting

If diagrams don't render:

- Verify Mermaid.js version matches

- Check browser console for errors

- Ensure JavaScript files are properly linked

Version Compatibility

Tested with:

- MDBook 0.4.40

- mdbook-mermaid 0.15.0

- Mermaid.js 8.11.0

- JotDown (latest version)

Tools I Currently Use

JotDown: A Powerful Tool for Notion Integration and Markdown Book Generation

In our documentation journey, I've found a valuable tool that significantly streamlines working with both Notion and markdown documentation: JotDown.

What is JotDown?

JotDown is a Model Context Protocol (MCP) server that enables large language models (LLMs) to interact seamlessly with Notion and generate Markdown Books. It provides two primary capabilities:

- Notion Integration: Create or update pages in Notion with content generated by LLMs

- Mdbook Generation: Generate a complete mdbook from content and manage its structure

Key Features

- 🌿 Notion Integration: Automatically create or update Notion pages with LLM-generated content

- 🌿 Mdbook Generation: Create and manage mdbooks directly, including generating files like

SUMMARY.md - 🌿 MCP Support: Maintains context over interactions for intelligent content creation

How to Install and Use JotDown

Prerequisites

- Rust: Install from rust-lang.org

- Notion API Token: You'll need an internal integration secret for Notion access

- Claude Desktop or other MCP client: Must be configured with a Notion integration token

Installation Steps

-

Clone the repository:

git clone https://github.com/Harry-027/JotDown cd jotdown -

Build the project:

cargo build --release -

Install mdbook CLI (required for book generation):

cargo install mdbook -

Setup Notion:

- Create an internal integration in your Notion workspace

- Set up a page titled "Jot It Down" and share it with your integration

-

Configure your MCP client (like Claude desktop):

"mcpServers": { "Jotdown": { "command": "/path_to_repo/Jotdown/target/release/Jotdown", "args": [], "env": { "NOTION_TOKEN": "your_notion_integration_token" } } } -

Restart your MCP client and start using JotDown!

Why I Recommend JotDown

JotDown has become an essential part of my documentation workflow because:

- Streamlined Integration: It bridges the gap between Notion (where I collect information) and mdbook (where I publish documentation)

- Automation: Automates tedious tasks like creating and organizing multiple markdown files

- Consistency: Ensures consistent structure across documentation

- Efficiency: Significantly reduces the time needed to transform content from Notion to published documentation

For anyone working with Notion and mdbook documentation, JotDown is a game-changer that can dramatically improve your productivity and documentation quality.

How to Generate and Serve Documentation

This guide explains how to install mdbook, integrate with JotDown, and generate NotionAiAssistant documentation locally.

Installing mdbook

mdbook is a tool written in Rust that generates beautiful books from Markdown files.

Installing via Cargo (Rust Package Manager)

If you already have Rust and Cargo installed:

cargo install mdbook

Installing via Precompiled Binaries

Alternatively, you can download precompiled binaries from the mdbook releases page.

Verifying the Installation

To verify that mdbook was installed correctly:

mdbook --version

JotDown Integration

For a seamless workflow between Notion and our MDBook documentation, we use JotDown:

Setting Up JotDown

-

Install JotDown from the repository:

git clone https://github.com/Harry-027/JotDown cd JotDown cargo build --release -

Configure your Notion API token:

export NOTION_TOKEN="your_notion_integration_token" -

Run JotDown to sync content from Notion to your documentation folder:

./target/release/JotDown

Automated Documentation Workflow

Our workflow combines Notion, JotDown, and MDBook:

- Write and organize content in Notion

- Use JotDown to convert Notion pages to Markdown files

- JotDown automatically organizes the content in your MDBook structure

- Generate the final documentation with mdbook

Generating the Documentation

Building the Book

To generate the static HTML files:

cd /path/to/NotionAiAssistant/docs

mdbook build

The files will be generated in the book/ folder inside the docs/ directory.

Serve Locally

To start a local server that updates automatically when files are changed:

cd /path/to/NotionAiAssistant/docs

mdbook serve

This will start a local web server, usually on port 3000. You can access the documentation at:

http://localhost:3000

Additional Options

- To specify a different port:

mdbook serve --port 8000

- To build and serve without automatically opening the browser:

mdbook serve --open false

Updating the Documentation

- Update content in Notion

- Run JotDown to sync changes to your local Markdown files

- If you are using

mdbook serve, the changes will be reflected automatically - If you are using

mdbook build, run the command again to regenerate the files

File Structure

SUMMARY.md: Define the structure of the book and summarybook.toml: Configuration of mdbook- Other

.mdfiles: Documentation content

Contributing Tips

- Keep formatting consistent

- Use web-optimized images

- Test the documentation locally before committing

- Keep the navigation logical in the SUMMARY.md file

- Use Notion for collaborative content creation, then sync with JotDown

Troubleshooting

Common Problems

-

"Command not found" error:

- Make sure mdbook is installed and in your PATH

-

Build error:

- Check links to images and other resources

- Check for Markdown syntax errors

-

Images not showing up:

- Check the relative paths to image references

-

JotDown sync issues:

- Verify your Notion API token is correct

- Ensure you have proper permissions in Notion

- Check if Notion API rate limits are affecting your sync

For more help, see the official mdbook documentation and the JotDown repository.

Open-Source Philosophy

The Journey of "My First Open-Source"

NotionAiAssistant represents more than just a technical project—it embodies a philosophy of open, collaborative, and accessible development. As our first significant open-source project, it incorporates fundamental principles that guided every technical and organizational decision.

graph LR

subgraph "Open-Source Pillars"

O["Open-Source<br>Philosophy"] --> T["Open<br>Technologies"]

O --> R["Rust as<br>Catalyst"]

O --> F["Simple<br>Tools"]

end

subgraph "Impacts"

O --> C["Customization<br>vs Services"]

O --> I["Community<br>Impact"]

C --> C1["Self-Hosted"]

C --> C2["Full Control"]

I --> I1["Reduced Barriers"]

I --> I2["Technology<br>Democratization"]

end

classDef core fill:#f9f,stroke:#333,stroke-width:2px

classDef pillar fill:#bbf,stroke:#333,stroke-width:2px

classDef impact fill:#bfb,stroke:#333,stroke-width:2px

class O core

class T,R,F,C,I pillar

class C1,C2,I1,I2 impact

Pillars of Our Open-Source Philosophy

1. End-to-End Open Technologies

A fundamental decision was to use exclusively open-source technologies throughout the project's stack:

| Component | Open-Source Technology | Avoided Proprietary Alternative |

|---|---|---|

| Frontend | Streamlit | Tableau, PowerBI |

| Backend | FastAPI, Python | Proprietary frameworks |

| Database | PostgreSQL | Oracle, SQL Server |

| Cache | Redis | Proprietary caching solutions |

| Containerization | Docker | Proprietary solutions |

| CI/CD | GitHub Actions | Jenkins Enterprise, CircleCI Premium |

| Documentation | mdbook (Rust) | Confluence, Notion |

| Observability | Prometheus, Grafana | Datadog, New Relic |

This deliberate choice provided us with:

- Full transparency: Anyone can inspect the workings

- Unlimited customization: Freedom to adapt any component

- Zero vendor lock-in: Flexibility to change any technology

- Broad community: Access to resources, tutorials, and community support

2. Rust as a Performance Catalyst

Our adoption of Rust in strategic parts of the project demonstrates our commitment to performance and efficiency:

Rust as a Python Package Compiler

Replacing pip with uv (written in Rust) revolutionized our build process:

# Before: ~3 minutes to install dependencies

pip install -r requirements.txt

# After: ~30 seconds for the same operation

uv pip install -r requirements.txt

Rust for Documentation

Choosing mdbook (written in Rust) for our documentation brought tangible benefits:

- Extremely fast generation: Documentation builds in milliseconds

- Minimal resource usage: Efficient operation even in limited environments

- Optimized reading experience: Smooth and responsive navigation

This hybrid approach—Python for rapid development and Rust for performance-critical components—represents a pragmatic model that leverages the best of each ecosystem.

3. Simple Tools, Powerful Results

We deliberately rejected unnecessary complexity in favor of simple yet effective tools:

# Our simple but effective deployment strategy

version: '3.8'

services:

app:

image: notionaiassistant:latest

restart: always

depends_on:

- postgres

environment:

- DATABASE_URL=postgresql://user:password@postgres:5432/notionai

postgres:

image: postgres:15

volumes:

- postgres_data:/var/lib/postgresql/data

environment:

- POSTGRES_USER=user

- POSTGRES_PASSWORD=password

- POSTGRES_DB=notionai

volumes:

postgres_data:

This minimalist philosophy is reflected throughout the project:

- Simple RESTful APIs instead of complex GraphQL

- Docker containers instead of complex orchestrators (when possible)

- SSH and bash scripts for deployment instead of heavy tools

- Markdown for documentation instead of proprietary systems

4. Customization vs. Managed Services

A core principle is the preference for self-hosted and customizable solutions:

- Custom VPS instead of managed cloud services

- Self-hosted database instead of RDS or other DBaaS

- Own CI/CD instead of exclusive SaaS solutions

This approach:

- Reduces operational costs significantly

- Increases control over every aspect of infrastructure

- Eliminates limitations imposed by managed services

- Provides valuable learning opportunities

A concrete example is our monitoring implementation:

# Simple but effective monitoring implementation

services:

prometheus:

image: prom/prometheus:latest

volumes:

- ./prometheus.yml:/etc/prometheus/prometheus.yml

ports:

- "9090:9090"

grafana:

image: grafana/grafana:latest

depends_on:

- prometheus

ports:

- "3000:3000"

volumes:

- grafana_data:/var/lib/grafana

Impact on Accessibility and Adoption

Our open-source philosophy directly impacted the project's accessibility:

-

Reduced entry barriers:

- Zero cost to start using

- Clear and comprehensive documentation

- Simplified setup with Docker

-

Deployment flexibility:

- Works from a Raspberry Pi to enterprise servers

- Can run locally or in the cloud

- Adapts to different needs and budgets

-

Learning and growth:

- Source code as an educational resource

- Opportunities for new developers to contribute

- Showcase of best practices in Python, Docker, and CI/CD

Challenges and Trade-offs

This approach also presented challenges:

-

Initial learning curve:

- Setting up self-hosted services requires technical knowledge

- Maintaining multiple services demands operational discipline

-

Operational responsibility:

- Self-hosting means responsibility for uptime and security

- Backups and disaster recovery must be implemented manually

-

Scaling limits:

- Simple solutions may require redesign at very large scales

- Load balancing and geographic distribution are more complex

However, we consider these challenges as valuable educational opportunities that enrich developers' experiences.

The Future of Open-Source

Our vision for the future of NotionAiAssistant and other open-source projects includes:

- Increased interoperability between open-source tools

- More Rust components for performance-critical parts

- Simplified deployments to reduce technical barriers

- Greater collaboration between Python and Rust communities

- Focus on sustainability of open-source development

Conclusion: Why This Matters

In a world of increasing technological centralization, open-source projects like NotionAiAssistant represent an important counterbalance:

- Democratize access to advanced AI technologies

- Educate users about how these technologies work

- Encourage experimentation and innovation outside large corporations

- Create communities around shared interests

- Return control to users over their tools and data

NotionAiAssistant is not just an assistant for Notion—it is a living demonstration that powerful technologies can be developed openly, transparently, and accessibly.

"Free software is a matter of liberty, not price. To understand the concept, you should think of 'free speech,' not 'free beer.'" - Richard Stallman

Our Story

The Origin of NotionAiAssistant

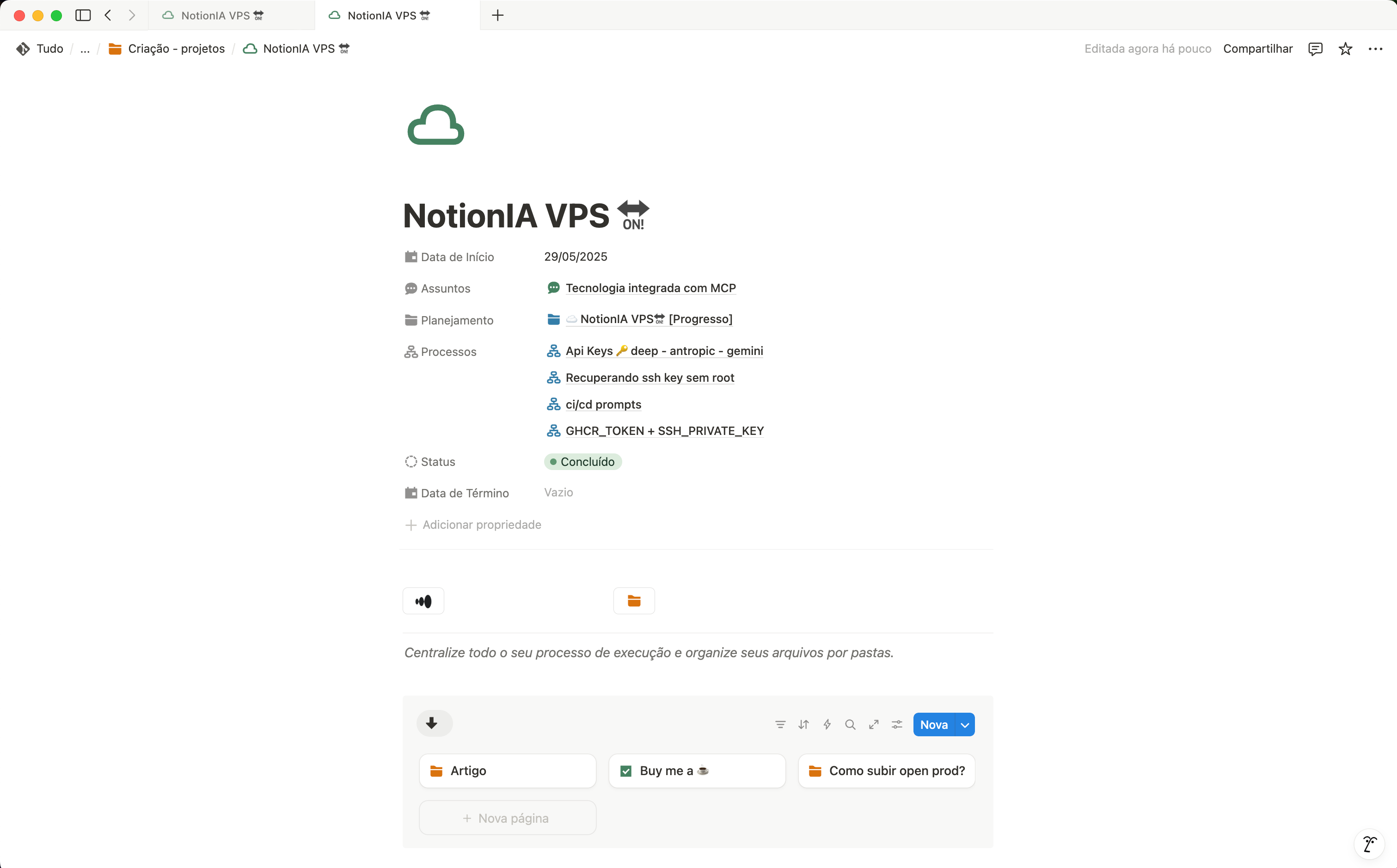

The NotionAiAssistant project was born out of the need to enhance the Notion experience with advanced artificial intelligence capabilities. As frequent Notion users, we realized there was immense potential to improve content organization, retrieval, and generation through integration with advanced language models.

From Idea to Implementation

Our journey began with a simple question: "What if we could talk to our Notion content?" From this question, we started developing a prototype that could:

- Connect to the Notion API

- Process and understand page content

- Use LLMs to provide intelligent responses

- Present everything in a simple and intuitive interface

What started as a personal experiment quickly evolved into a complete tool that could benefit the entire Notion user community.

Why Open-Source?

We decided to make NotionAiAssistant an open-source project for several reasons:

- Accessibility: We wanted AI technology to be accessible to everyone, not just those who can afford commercial solutions

- Transparency: We believe AI solutions should be transparent, allowing users to understand how their data is processed

- Collaboration: We knew community collaboration could elevate the project to levels we couldn't achieve alone

- Learning: Open-source development creates learning opportunities for everyone involved

Vision for the Future

Our vision is to make NotionAiAssistant a robust and versatile solution that enables:

- Integration with multiple language models

- Support for various use cases beyond Notion

- An active community of contributors and users

- Continuous improvement with new features and enhancements

We are just at the beginning of this journey and invite you to be part of it!

"Every great project starts with a simple idea and the courage to implement it."

Challenges and Learnings

During the development of NotionAiAssistant, we faced various technical and organizational challenges that became valuable learning opportunities. This section documents some of the key lessons we learned along the way.

Technical Challenges

1. Integration with the Notion API

One of the biggest challenges was working with the limitations of the Notion API:

- Request limits that required the implementation of rate-limiting mechanisms

- Complex block structure that needed to be properly mapped to our data model

- Authentication and authorization that needed to be secure yet user-friendly

This challenge taught us a lot about working with third-party APIs and designing resilient systems that can adapt to external constraints.

2. Context Management for LLMs

Working with language models brought unique challenges:

- Token limitations that required efficient chunking and summarization strategies

- Response consistency that demanded careful prompt engineering

- Balancing cost and quality of API queries

We learned a great deal about optimizing prompts, managing context, and creating AI experiences that are both powerful and cost-effective.

3. Development with Docker

The decision to use Docker for our development environment introduced initial challenges:

- Build time that initially impacted developer productivity

- Hot reload configuration for real-time updates during development

- Consistency between development and production environments

These difficulties led to significant optimizations that ultimately benefited the entire development workflow.

Organizational Learnings

1. Managing an Open-Source Project

Maintaining an organized open-source project requires:

- Clear and comprehensive documentation to facilitate contributions

- Consistent coding standards to maintain quality

- Review processes that are rigorous yet welcoming

We learned that investing time in project organization from the start saves a lot of effort in the long run.

2. Balancing Features and Quality

An important lesson was finding the balance between:

- Adding new features to make the project more attractive

- Refining existing features to ensure robustness

- Fixing bugs and technical issues to maintain reliability

We discovered that prioritizing quality and user experience over the quantity of features always pays off.

3. The Importance of Feedback

Feedback from early users was crucial for:

- Identifying unnoticed issues during development

- Understanding real-world use cases beyond our initial assumptions

- Prioritizing improvements based on user needs

This process taught us to value continuous feedback as an essential part of the development cycle.

Lessons for Future Projects

If we could go back in time, some decisions we would make from the start:

- Establish automated testing earlier in the development cycle

- Create detailed documentation alongside the code, not afterward

- Implement monitoring and logging from the first versions

- Define a clear versioning strategy before the first release

"Obstacles are those frightful things you see when you take your eyes off your goal." - Henry Ford

Special Thanks to:

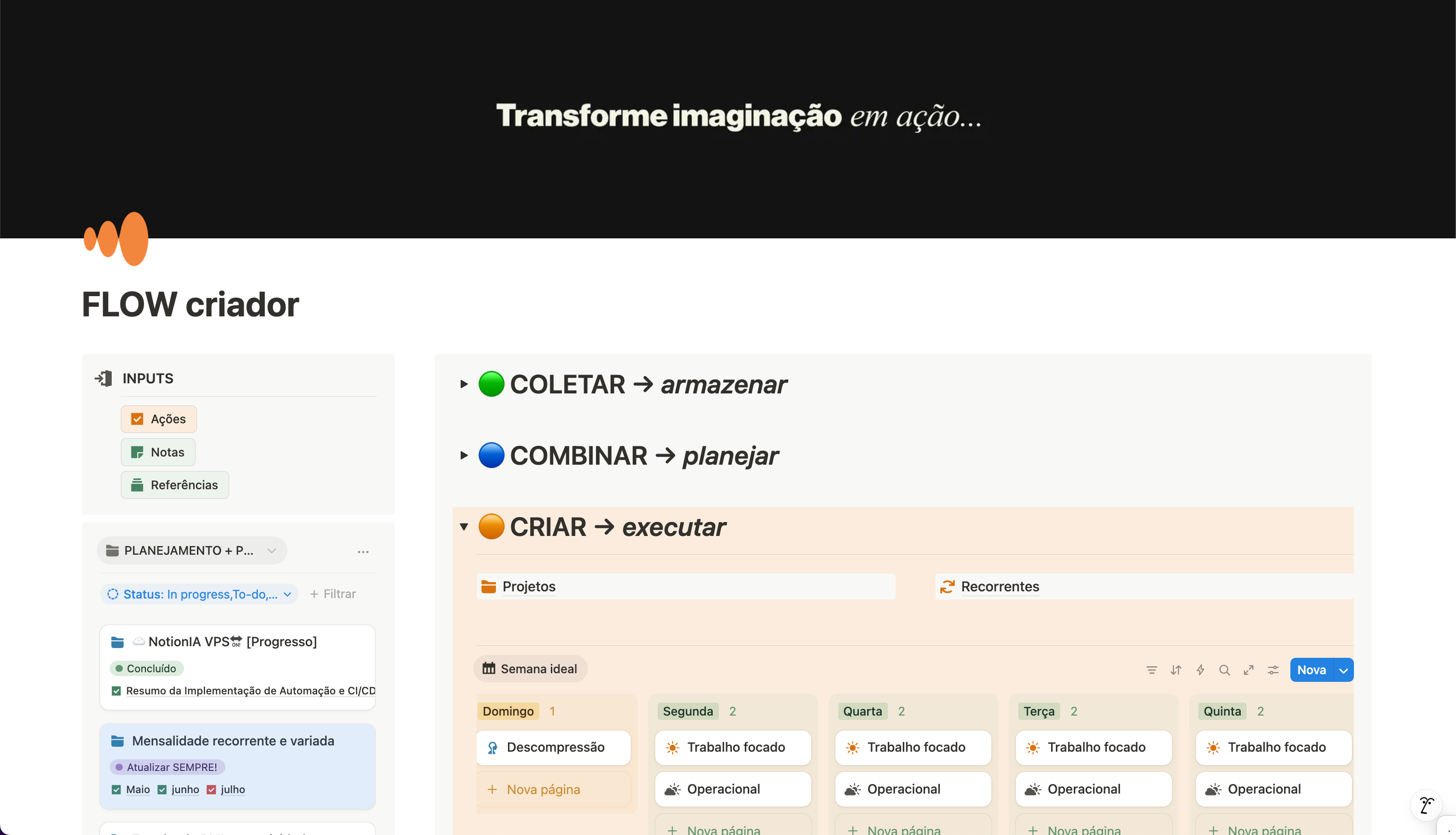

We would like to express our deepest gratitude to FlowCriador and its incredible methodology, which was a true turning point in the development of this project.

We also extend our sincere thanks to our friend Harry to create JotDown ,a remarkable tool that has been instrumental in building this documentation. JotDown's seamless integration between Notion and MDBook has significantly streamlined our documentation process, allowing us to maintain a single source of truth in Notion while automatically generating beautiful, well-structured markdown documentation.

How FlowCriador Transformed Our Project

FlowCriador was instrumental in our development process through its three-step methodology:

1. Collect

The tool allowed us to collect and organize information in a structured way in Notion, creating a solid knowledge base for our project. This enabled us to:

- Catalog requirements and functionalities in an organized manner

- Document research and technical references

- Record design and architecture decisions

2. Combine

With FlowCriador's methodology, we were able to combine different ideas and concepts to:

- Identify patterns and connections between different aspects of the project

- Generate new ideas by combining existing concepts

- Visualize the project holistically

3. Create

The final stage of the methodology guided us in transforming ideas into concrete implementations:

- Converting concepts into functional code

- Turning prototypes into finished products

- Implementing efficient workflows

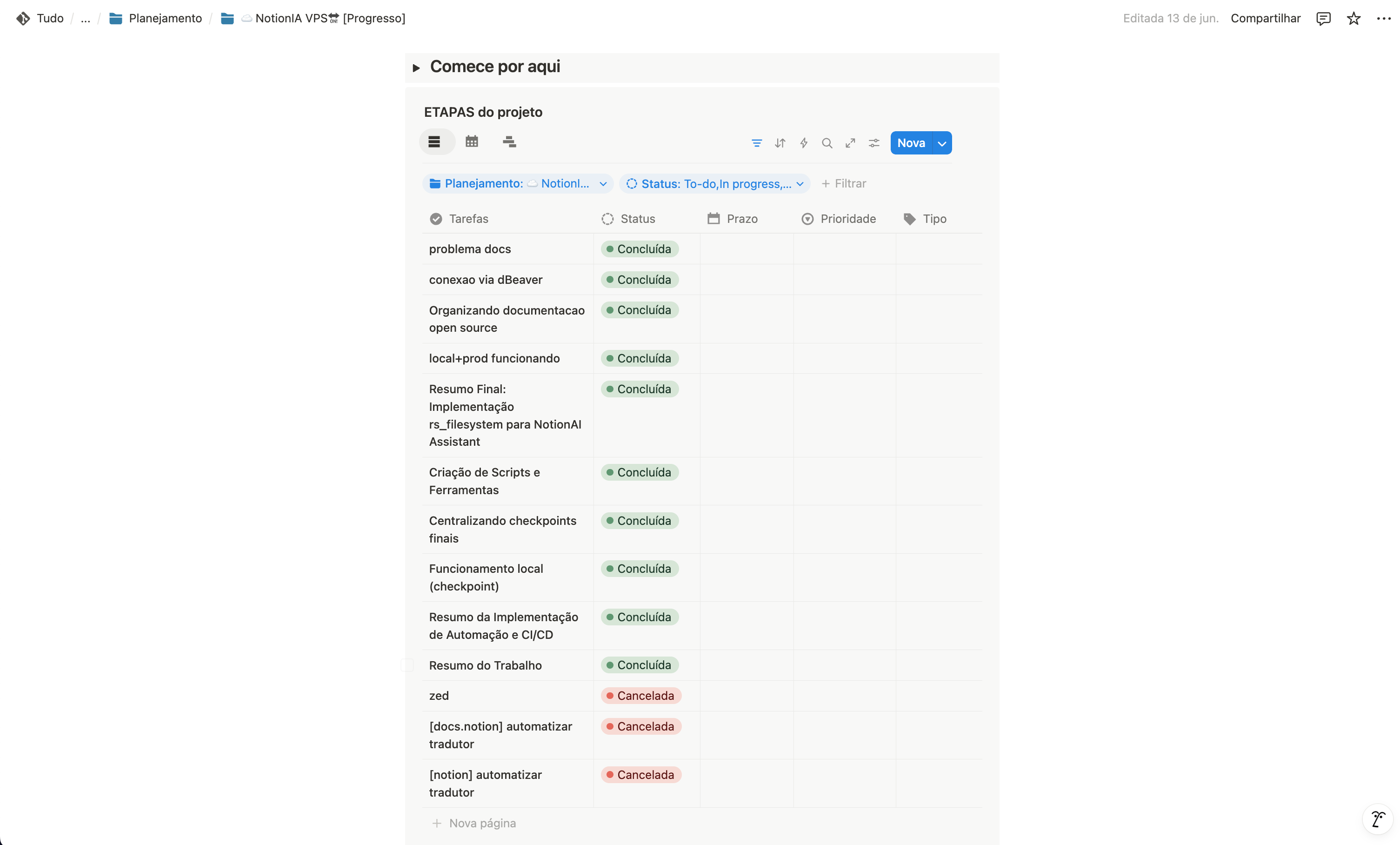

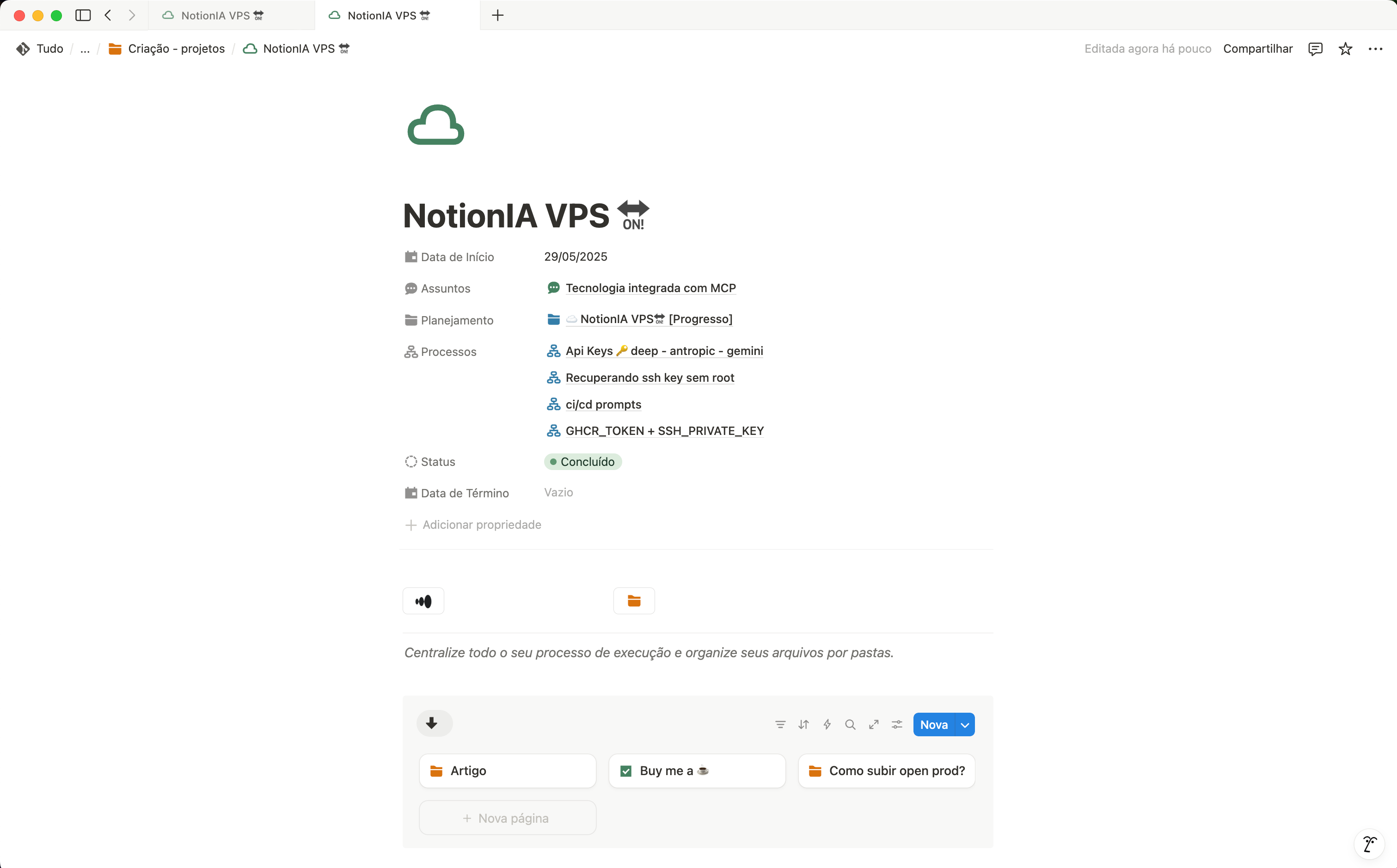

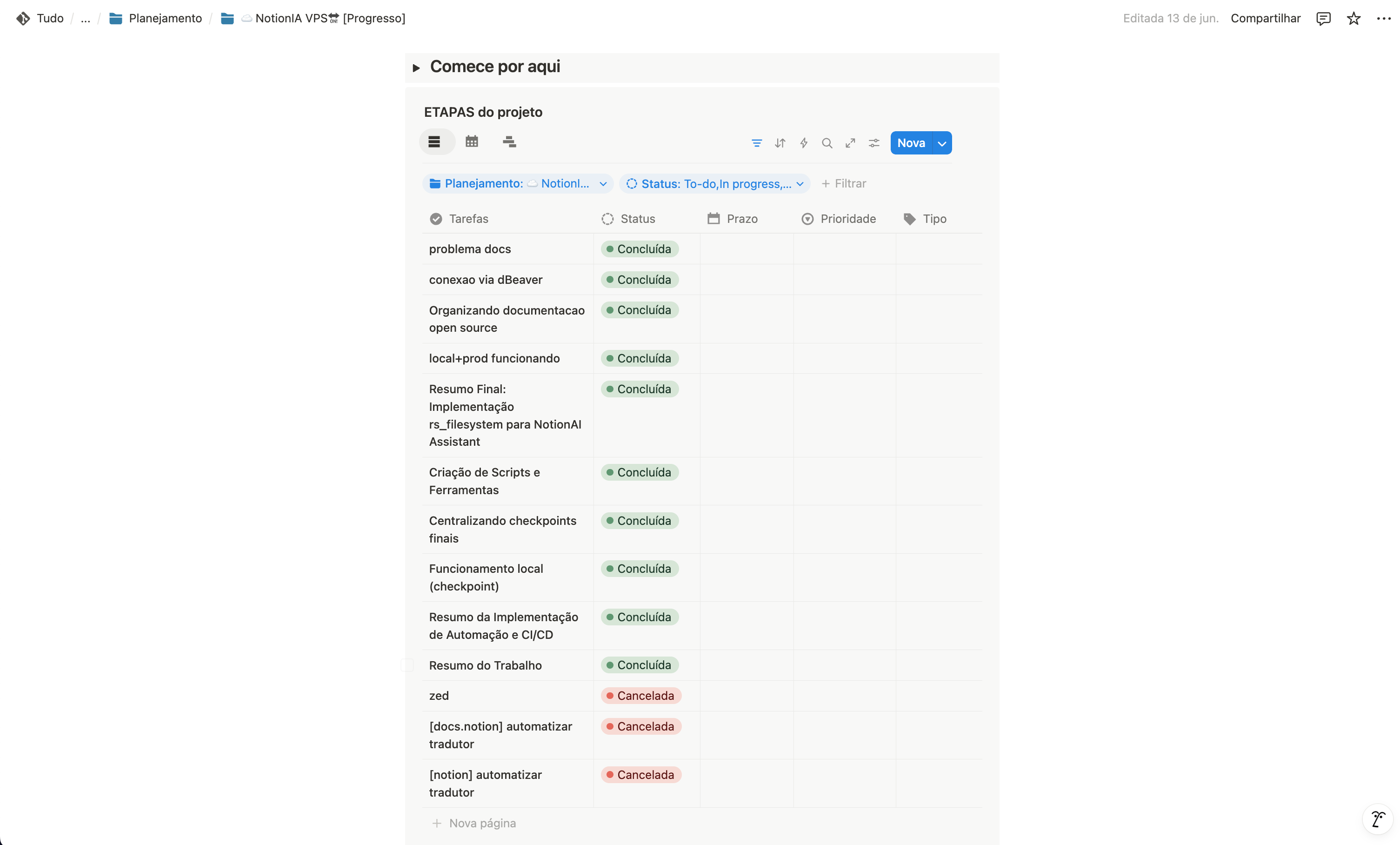

Impact on NotionAiAssistant

We started our development journey using FlowCriador methodology to organize our ideas

Tracking our development progress systematically using FlowCriador

Successfully completing the NotionAiAssistant project using structured methodology

FlowCriador's methodology allowed us to:

- Stay focused on the project's main goals

- Organize development efficiently

- Adapt quickly to new needs and feedback

- Prioritize features based on real value for users

Acknowledgments to the Open-Source Community

This project would not be possible without the incredible tools, libraries, and frameworks developed by the open-source community. We would especially like to thank:

- Python Community: For creating and maintaining a language that is both powerful and accessible

- FastAPI Team: For developing a framework that combines performance and ease of use

- Streamlit Team: For providing tools that simplify interface creation

- Docker Community: For revolutionizing how we develop and deploy applications

- PostgreSQL Community: For maintaining one of the most robust and reliable databases

- Notion Team: For creating an API that enables powerful integrations

- GitHub: For providing tools that facilitate collaboration and open-source development

- Henry (Harry-027): For creating and open-sourcing JotDown, a valuable tool that enables LLMs to interact with Notion and generate markdown books

Acknowledgments to Contributors

We thank every person who contributed to this project, whether through code, documentation, testing, feedback, or simply sharing it with others. Every contribution, no matter how small, was essential to getting us where we are.

A Final Thank You

Finally, we thank you for reading this documentation. Whether you are a user, a potential contributor, or just someone curious about our project, your attention and interest are what give meaning to our work.

"Alone we can do so little; together we can do so much." - Helen Keller

Bem-vindo à Nossa História de Desenvolvimento

Este livro documenta a fascinante jornada por trás do desenvolvimento do Notion Assistant, um assistente de inteligência artificial open-source para o Notion.

Ao longo destas páginas, compartilhamos:

- 📚 Nossa história e motivação para criar este projeto

- 🧠 Os aprendizados e desafios que enfrentamos

- 🔧 As soluções técnicas que implementamos

- 🙏 Agradecimentos especiais aos que tornaram isso possível

Esta documentação serve como um complemento à documentação técnica completa para desenvolvedores, focando mais nos aspectos humanos e nas lições aprendidas durante o processo de desenvolvimento.

Nota: Para a documentação técnica detalhada sobre como usar, configurar e contribuir com o projeto, consulte nossa documentação para desenvolvedores.

Por que Compartilhamos Nossa Jornada?

Acreditamos que o processo de construção é tão valioso quanto o produto final. Ao documentar nossa experiência:

- Inspiramos outros desenvolvedores a iniciar seus próprios projetos open-source

- Compartilhamos soluções para problemas comuns que outros podem enfrentar

- Celebramos a comunidade que tornou este projeto possível

- Documentamos nossa evolução para referência futura

Esperamos que este relato sirva como inspiração e referência para desenvolvedores, entusiastas de IA e qualquer pessoa interessada em como soluções de software são construídas na prática.

Este é um projeto open-source construído com ❤️ e muito ☕

Docker para Desenvolvimento

A Evolução do Nosso Ambiente de Desenvolvimento

Quando iniciamos o desenvolvimento do NotionAiAssistant, rapidamente percebemos que um ambiente de desenvolvimento consistente e fácil de configurar seria essencial para o sucesso do projeto, especialmente como uma iniciativa open-source que buscava atrair contribuidores.

graph LR

subgraph "Antes: Desenvolvimento Fragmentado"

PL["Python<br>Local"] --> P1["Inconsistências<br>de Ambiente"]

PL --> P2["Diferentes<br>Versões"]

P3["Configuração<br>Complexa"]

end

subgraph "Depois: Docker Unificado"

DC["Docker<br>Compose"] --> B1["Hot<br>Reload"]

DC --> B2["Volumes<br>Sincronizados"]

DC --> B3["Ambiente<br>Consistente"]

end

I["Desenvolvedor"] --> A

I --> D

A -.-> |Evolução| D

classDef antes fill:#ffcccc,stroke:#333,stroke-width:2px

classDef depois fill:#ccffcc,stroke:#333,stroke-width:2px

classDef dev fill:#bbf,stroke:#333,stroke-width:2px

class A,PL,P1,P2,P3 antes

class D,DC,B1,B2,B3 depois

class I dev

O Desafio Inicial: Desenvolvimento Python Local

Inicialmente, nosso fluxo de desenvolvimento era fragmentado:

- Python executado localmente na máquina do desenvolvedor

- Banco de dados PostgreSQL em um container Docker separado

- Frontend Streamlit em outro processo local

Este modelo apresentava vários problemas:

- Inconsistências de ambiente: "Funciona na minha máquina" era um problema recorrente

- Configuração complexa: novos contribuidores precisavam seguir instruções detalhadas

- Diferentes versões de dependências: causavam bugs difíceis de rastrear

- Alto nível de conhecimento técnico necessário: barreira para contribuidores menos experientes

A Solução: Hot Reload no Docker de Desenvolvimento

Nossa grande evolução foi a implementação de um ambiente Docker de desenvolvimento com hot reload integrado:

# Trecho do nosso Dockerfile.dev

FROM python:3.10-slim as dev

WORKDIR /app

# Instalação de dependências com uv para maior velocidade

COPY requirements-dev.txt .

RUN pip install --no-cache-dir uv

RUN uv pip install --no-cache-dir -r requirements-dev.txt

# Configuração para hot reload

ENV PYTHONDONTWRITEBYTECODE=1

ENV PYTHONUNBUFFERED=1

# Ponto de entrada que inicia o app com hot reload

ENTRYPOINT ["python", "-m", "uvicorn", "app.main:app", "--host", "0.0.0.0", "--port", "8080", "--reload"]

Combinado com o mapeamento de volume no docker-compose:

# Trecho do docker-compose.dev.yml

services:

app:

build:

context: .

target: dev

volumes:

- ./app:/app/app

- ./config:/app/config

# ...

Benefícios Transformadores

Esta abordagem trouxe benefícios extraordinários:

1. Produtividade Amplificada

- Hot reload automático: alterações no código são refletidas instantaneamente no navegador

- Feedback imediato: os desenvolvedores veem os resultados sem reiniciar containers

- Fluxo de trabalho contínuo: menos interrupções, mais produtividade

2. Experiência Simplificada para Contribuidores

- Um único comando para iniciar:

docker-compose -f docker-compose.dev.yml up - Sem configuração local complexa: tudo funciona dentro do container

- Ambiente consistente: todos os desenvolvedores têm exatamente o mesmo ambiente

3. Acessibilidade para Diferentes Níveis de Experiência

- Desenvolvedores Python: podem contribuir sem conhecer Docker profundamente

- Desenvolvedores iniciantes: barreira de entrada significativamente reduzida

- Contribuidores não-técnicos: podem testar e fornecer feedback facilmente

Como Funciona na Prática

O fluxo de trabalho se tornou incrivelmente simples:

-

Clone o repositório:

git clone https://github.com/seu-usuario/NotionAiAssistant.git cd NotionAiAssistant -

Inicie o ambiente de desenvolvimento:

docker-compose -f docker-compose.dev.yml up -

Comece a desenvolver:

- Edite os arquivos em sua IDE favorita

- As alterações são detectadas automaticamente

- A aplicação é recarregada em segundos

- Veja as mudanças no navegador em tempo real

Comparação Antes e Depois

| Aspecto | Antes | Depois |

|---|---|---|

| Tempo para iniciar | 5-10 minutos | 1-2 minutos |

| Configuração inicial | Complexa, vários passos | Um único comando |

| Feedback após mudanças | 30-60 segundos | 1-2 segundos |

| Consistência entre devs | Variável | 100% consistente |

| Barreira para contribuição | Alta | Baixa |

Lições e Práticas Recomendadas

Nossa experiência nos ensinou algumas práticas valiosas:

- Priorize a experiência do desenvolvedor desde o início do projeto

- Otimize o tempo de feedback - quanto mais rápido, melhor

- Simplifique a entrada para novos contribuidores

- Documente claramente o fluxo de trabalho de desenvolvimento

- Teste seu ambiente com desenvolvedores de diferentes níveis de experiência

Impacto no Projeto

A implementação do hot reload no Docker transformou fundamentalmente nosso projeto:

- Aumento de contribuições: mais pessoas puderam participar facilmente

- Ciclos de desenvolvimento mais rápidos: features implementadas em menos tempo

- Melhor qualidade de código: mais iterações e experimentação

- Comunidade mais engajada: barreira reduzida para participação

Esta abordagem se tornou um dos pilares da filosofia do nosso projeto: tecnologia avançada que parece simples para o usuário final.

"A melhor ferramenta não é aquela com mais recursos, mas a que remove obstáculos do seu caminho."

Segurança com Docker Secrets

O Desafio de Gerenciar Segredos em Aplicações

O gerenciamento de segredos e configurações sensíveis é um desafio crítico em qualquer aplicação, especialmente em projetos open-source. Desde o início do NotionAiAssistant, consideramos a segurança como uma prioridade, e o gerenciamento adequado de credenciais e tokens de API era essencial.

graph LR

subgraph "Fluxo de Docker Secrets"

S1["Arquivos de Secrets<br>Local/CI/Produção"] --> S2["Docker Compose<br>Referencia Secrets"]

S2 --> S3["Montados em<br>/run/secrets/"]

S3 --> S4["Aplicação<br>Lê do Filesystem"]

end

subgraph "Benefícios de Segurança"

S4 --> V1["Não Aparecem<br>em Logs"]

S4 --> V2["Não Expostos<br>em Variáveis"]

S4 --> V3["Não Incluídos<br>em Imagens"]

end

classDef source fill:#f9f,stroke:#333,stroke-width:2px

classDef flow fill:#bbf,stroke:#333,stroke-width:2px

classDef benefit fill:#bfb,stroke:#333,stroke-width:2px

class S1 source

class S2,S3,S4 flow

class V1,V2,V3 benefit

Por Que Docker Secrets?

Existem diversas soluções para gerenciamento de segredos disponíveis no mercado, como:

- HashiCorp Vault

- AWS Secrets Manager

- Google Secret Manager

- Kubernetes Secrets

- Variáveis de ambiente criptografadas

- Arquivos .env com ferramentas como dotenv

No entanto, escolhemos Docker Secrets pelos seguintes motivos:

1. Integração Nativa com Nosso Stack

Como já estávamos utilizando Docker e Docker Compose para nosso ambiente de desenvolvimento e produção, o Docker Secrets oferecia uma integração perfeita sem necessidade de ferramentas adicionais.

2. Simplicidade e Baixa Curva de Aprendizado

O Docker Secrets apresenta uma abordagem direta e intuitiva:

# Exemplo de uso no docker-compose.yml

services:

app:

image: notionaiassistant:latest

secrets:

- notion_api_key

- database_password

- openai_api_key

secrets:

notion_api_key:

file: ./secrets/notion_api_key.txt

database_password:

file: ./secrets/database_password.txt

openai_api_key:

file: ./secrets/openai_api_key.txt

3. Segurança em Diferentes Ambientes

O Docker Secrets nos permitiu implementar uma estratégia consistente para diferentes ambientes:

- Desenvolvimento: Secrets armazenados localmente em arquivos

- CI/CD: Secrets injetados a partir de variáveis de ambiente

- Produção: Secrets gerenciados pelo Docker Swarm

4. Evita Exposição Acidental

O Docker Secrets reduz significativamente o risco de exposição acidental de credenciais:

- Não aparecem em logs ou saídas de comandos

- Não são expostos através de variáveis de ambiente

- Não são incluídos em imagens ou containers

- São montados como arquivos temporários em

/run/secrets/

Implementação no NotionAiAssistant

Nossa implementação de Docker Secrets segue um padrão consistente em todo o projeto:

1. Estrutura de Diretórios

NotionAiAssistant/

├── secrets/

│ ├── .gitignore # Ignora todos os arquivos exceto templates

│ ├── notion_api_key.txt.template

│ ├── database_password.txt.template

│ └── ...

2. Acesso aos Secrets no Código

Implementamos uma função auxiliar para acessar secrets de forma consistente:

def get_secret(secret_name: str) -> str:

"""

Obtém um secret do Docker Secrets ou fallback para variável de ambiente.

Args:

secret_name: Nome do secret a ser obtido

Returns:

Conteúdo do secret como string

"""

# Caminho padrão do Docker Secrets

secret_path = f"/run/secrets/{secret_name}"

# Verifica se o secret existe como arquivo

if os.path.exists(secret_path):

with open(secret_path, "r") as f:

return f.read().strip()

# Fallback para variável de ambiente (desenvolvimento local ou CI)

env_var = os.environ.get(secret_name.upper())

if env_var:

return env_var

raise ValueError(f"Secret {secret_name} não encontrado")

3. Configuração para Novos Contribuidores

Criamos um script de setup que facilita a configuração inicial:

#!/bin/bash

# setup-secrets.sh

echo "Configurando secrets para ambiente de desenvolvimento..."

mkdir -p secrets

for template in secrets/*.template; do

secret_file="${template%.template}"

if [ ! -f "$secret_file" ]; then

echo "Criando $secret_file"

echo "development_value" > "$secret_file"

echo "⚠️ Lembre-se de substituir o valor padrão em $secret_file com suas credenciais reais"

fi

done

echo "✅ Setup concluído!"

Benefícios Práticos Observados

A adoção do Docker Secrets trouxe benefícios tangíveis ao projeto:

- Zero exposição acidental de credenciais em commits ou logs

- Processo de onboarding simplificado para novos contribuidores

- Consistência entre ambientes de desenvolvimento e produção

- Rotação de credenciais facilitada sem necessidade de reconstruir imagens

- Auditabilidade melhorada de acesso a informações sensíveis

Comparação com Alternativas

| Solução | Complexidade | Integração com Docker | Curva de Aprendizado | Custo |

|---|---|---|---|---|

| Docker Secrets | Baixa | Nativa | Baixa | Gratuito |

| HashiCorp Vault | Alta | Requer configuração | Alta | Gratuito/Pago |

| Cloud Providers | Média | Requer SDK/API | Média | Pago |

| .env Files | Baixa | Manual | Baixa | Gratuito |

Lições Aprendidas

Nossa experiência com Docker Secrets nos ensinou importantes lições:

- A solução mais simples muitas vezes é a melhor: não precisamos de ferramentas complexas para resolver problemas básicos

- Soluções nativas trazem menos atrito: usar o que já está disponível no ecossistema reduz pontos de falha

- Documentação clara é essencial: especialmente para aspectos relacionados à segurança

- Padrões consistentes aumentam a segurança: uma abordagem uniforme facilita auditoria e manutenção

Conclusão

A escolha do Docker Secrets demonstrou que, em muitos casos, as ferramentas nativas do ecossistema que você já utiliza podem oferecer soluções elegantes para problemas complexos. Em vez de adicionar mais complexidade com ferramentas especializadas, primeiro avalie o que já está disponível em seu stack atual.

Esta abordagem alinha-se perfeitamente com nossa filosofia de projeto: utilizar tecnologias open-source simples e eficazes para criar soluções robustas e acessíveis.

"A simplicidade é o último grau da sofisticação." - Leonardo da Vinci

GitHub e CI/CD

A Magia do GitHub na Evolução do Projeto

A escolha do GitHub como plataforma para hospedar nosso projeto foi um dos fatores determinantes para o sucesso do NotionAiAssistant. Muito além de um simples repositório de código, o GitHub se tornou o centro nervoso de todo nosso processo de desenvolvimento, colaboração e entrega contínua.

graph LR

subgraph "Fluxo de Desenvolvimento"

D1["Desenvolvedor<br>Cria Branch"] --> D2["Implementa<br>Feature/Fix"]

D2 --> D3["Cria Pull<br>Request"]

end

D3 --> C1

subgraph "CI/CD Pipeline"

C1["GitHub Actions<br>Detecta PR"] --> C2["Testes e<br>Linters"]

C2 -->|Passa| C3["Review<br>por Pares"]

C3 -->|Aprovado| C4["Merge<br>para Main"]

C4 --> C5["Deploy<br>Automático"]

C2 -.->|Falha| D2

end

classDef dev fill:#bbf,stroke:#333,stroke-width:2px

classDef ci fill:#f9f,stroke:#333,stroke-width:2px

classDef deploy fill:#bfb,stroke:#333,stroke-width:2px

class D1,D2,D3 dev

class C1,C2,C3,C4 ci

class C5 deploy

Versionamento: A Base de Tudo

O sistema de controle de versão Git, combinado com a interface intuitiva do GitHub, nos proporcionou:

1. Histórico Completo e Transparente

Cada decisão, implementação e correção está documentada através de commits e pull requests, criando um histórico completo da evolução do projeto.

# Exemplo de log de commits que conta uma história

$ git log --oneline --graph --decorate --all

* a1b2c3d (HEAD -> main) Otimiza performance da busca em blocos de texto

* e4f5g6h Adiciona suporte para formatação de tabelas no Notion

* i7j8k9l Corrige bug na divisão de conteúdo extenso

* m0n1o2p Implementa algoritmo de chunking inteligente

* q3r4s5t Versão inicial da integração com API do Notion

2. Colaboração Facilitada

O modelo de fork e pull request do GitHub democratizou a contribuição para o projeto:

- Desenvolvedores podem experimentar em seus próprios forks

- Pull requests permitem revisão de código detalhada

- Discussões ficam documentadas permanentemente

- Contribuidores ocasionais podem participar sem acesso direto ao repositório

3. Gestão de Releases e Tags

O GitHub simplificou nosso processo de versionamento semântico:

- Tags para marcar versões estáveis

- Releases com notas detalhadas

- Assets compilados disponíveis para download

- Histórico de mudanças claramente documentado

GitHub Actions: CI/CD Sem Esforço

A verdadeira magia aconteceu quando implementamos GitHub Actions para automatizar nosso pipeline de integração e entrega contínua.

1. Testes Automatizados em Cada PR

# Trecho do nosso workflow de testes

name: Tests

on:

pull_request:

branches: [ main ]

push:

branches: [ main ]

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python

uses: actions/setup-python@v4

with:

python-version: '3.10'

- name: Install dependencies

run: |

python -m pip install --upgrade pip

pip install uv

uv pip install -r requirements-dev.txt

- name: Run tests

run: pytest

- name: Run linters

run: make lint

Este workflow garante que:

- Todos os testes passam antes do merge

- O código segue os padrões de estilo definidos

- Problemas são identificados precocemente

2. Deploy Automatizado para Produção

Nosso pipeline de deploy é acionado automaticamente quando ocorrem mudanças na branch principal:

# Trecho do nosso workflow de deploy

name: Deploy

on:

push:

branches: [ main ]

jobs:

deploy:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Docker Buildx

uses: docker/setup-buildx-action@v2

- name: Build and push

uses: docker/build-push-action@v4

with:

context: .

push: true

tags: ${{ secrets.DOCKER_REGISTRY }}/notionaiassistant:latest

- name: Deploy to server

uses: appleboy/ssh-action@master

with:

host: ${{ secrets.SERVER_HOST }}

username: ${{ secrets.SERVER_USER }}

key: ${{ secrets.SSH_PRIVATE_KEY }}

script: |

cd /opt/notionaiassistant

docker-compose pull

docker-compose up -d

Este workflow automatiza todo o processo de entrega:

- Build de uma nova imagem Docker

- Push para o registro de containers

- Deploy no servidor de produção

- Tudo sem intervenção manual

3. Workflows Adicionais para Qualidade

Além dos workflows principais, implementamos automações adicionais:

- Verificação de dependências: Dependabot para manter bibliotecas atualizadas

- Preview de ambientes: Ambientes temporários para testar pull requests

- Geração de documentação: Atualização automática da documentação

- Análise de código: Integração com ferramentas como CodeQL para segurança

Issues e Projects: Gerenciamento Transparente

O sistema de Issues do GitHub se tornou nosso hub central para:

- Rastreamento de bugs: Relatórios detalhados e reproduzíveis

- Solicitações de funcionalidades: Discussões sobre novas implementações

- Planejamento de releases: Organização visual com GitHub Projects

- Documentação de decisões: Discussões que levam a escolhas arquiteturais

A natureza pública desse processo permitiu que usuários e contribuidores participassem ativamente do direcionamento do projeto.

GitHub Pages: Documentação Acessível

Utilizamos GitHub Pages para hospedar nossa documentação:

- Gerada automaticamente a partir do código-fonte

- Atualizada a cada push para a branch principal

- Integrada com o mdbook para uma experiência de leitura agradável

- Acessível através de um domínio personalizado

Lições Aprendidas

Nossa experiência com GitHub e CI/CD nos ensinou:

- Automatize tudo o que for possível: Cada etapa manual é uma oportunidade para erros

- Testes são essenciais: Não há CI/CD efetivo sem uma boa cobertura de testes

- Feedback rápido é crucial: Workflows devem ser otimizados para velocidade

- Documentação deve evoluir com o código: Automatize sua atualização

- Transparência beneficia todos: Processos abertos fomentam colaboração

Benefícios Tangíveis Observados

A adoção dessas práticas resultou em:

- Redução de 90% no tempo de deploy: De horas para minutos

- Diminuição de bugs em produção: Problemas são detectados antes do merge

- Aumento na confiança dos desenvolvedores: Mudanças podem ser feitas com segurança

- Maior engajamento da comunidade: Contribuidores entendem o processo facilmente

Conclusão

O GitHub e suas ferramentas integradas de CI/CD foram fundamentais para transformar o NotionAiAssistant de um projeto pessoal em uma solução robusta e colaborativa. A "magia" do GitHub não está apenas em suas ferramentas técnicas, mas na forma como elas facilitam a colaboração humana e promovem práticas de desenvolvimento de alta qualidade.

Recomendamos fortemente que qualquer projeto open-source aproveite ao máximo esses recursos, pois eles amplificam significativamente o impacto e a qualidade das contribuições da comunidade.

"O código é apenas uma parte do desenvolvimento de software. A colaboração, processos e ferramentas são igualmente importantes."

Contornando o Limite da API do Notion

O Desafio das Limitações da API

Um dos maiores desafios técnicos que enfrentamos no desenvolvimento do NotionAiAssistant foi lidar com as limitações da API do Notion, especialmente quando precisávamos criar páginas com conteúdo extenso e formatação Markdown.

flowchart TD

A[Conteúdo Markdown] --> B{Limitações da API Notion}

B -->|Limite de 2000 caracteres por bloco| C[Divisão Inteligente de Conteúdo]

B -->|Formatação especial para Markdown| D[Parser de Markdown Personalizado]

B -->|Limite de 100 blocos por requisição| E[Envio em Lotes]

C --> F[Smart Chunking Algorithm]

D --> G[Mapeamento de Markdown para Blocos Notion]

E --> H[Fila de Processamento com Retry]

F --> I[Resultado Final]

G --> I

H --> I

I --> J[Página Notion com Conteúdo Formatado Completo]

style B fill:#f96,stroke:#333,stroke-width:2px

style I fill:#9f6,stroke:#333,stroke-width:2px

style J fill:#69f,stroke:#333,stroke-width:2px

As Três Principais Limitações

A API do Notion impõe três restrições significativas que afetaram diretamente nossa implementação:

1. Limite de 2000 Caracteres por Bloco de Texto

"Erro: O conteúdo excede o limite máximo de 2000 caracteres por bloco"

Este limite impossibilitava a criação direta de blocos de texto grandes, como artigos, documentações ou relatórios extensos, que são comuns em ambientes produtivos.

2. Necessidade de Formatação Especial para Markdown

O Notion não aceita Markdown puro em sua API. Em vez disso, ele requer uma estrutura específica de blocos com formatação própria, o que tornava complexa a conversão de conteúdo Markdown para o formato esperado pela API.

3. Limite de 100 Blocos por Requisição

"Erro: Número máximo de blocos por requisição excedido (máximo: 100)"